La digitalización de la guerra

Giulio De Petra.

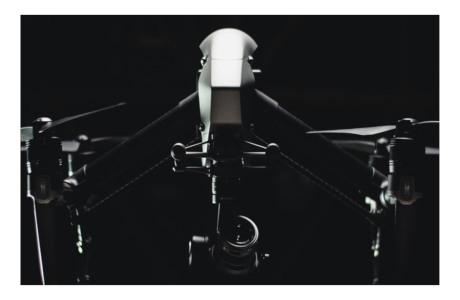

Foto: Detalle de la foto de Tembela Bohle: https://www.pexels.com/it-it/foto/foto-in-bianco-e-nero-di-drone-2050718/

Las infraestructuras, las armas autónomas y los sistemas predictivos basados en la IA son los ámbitos de la relación cada vez más estrecha entre el uso civil y el uso militar de las tecnologías digitales. Pero la narrativa de la IA también es un instrumento de guerra.

Intervención en la iniciativa «Guerra y tecnologías: el complejo digital-militar», celebrada el 20.01. 2025, en el ciclo “Guerra, paz, sistema mundial”, promovido por la Universidad de Roma “La Sapienza” junto con la Fundación Lelio y Lisli Basso, en colaboración con la Campaña Sbilanciamoci!, la Red Italiana por la Paz y el Desarme, Greenpeace Italia y con el patrocinio de RUniPace – Red de Universidades por la Paz.

El uso de tecnologías digitales en los teatros de guerra no es reciente, pero sin duda ha tenido un fuerte impulso en los últimos años. La guerra entre Rusia y Ucrania y la guerra entre Israel y Palestina son los escenarios donde más claramente se pueden observar las características de la combinación cada vez más estrecha entre tecnologías digitales y dispositivos militares (se ha escrito recientemente sobre esto en esta página web).

Para comprender mejor las implicaciones, es útil dividir y analizar esta combinación en tres ámbitos tecnológicos: el de las infraestructuras; el de las armas autónomas; y el de los sistemas predictivos de apoyo a la toma de decisiones basados en la IA.

Civil y militar

Sin embargo, antes de analizarlos, es útil señalar una característica que atraviesa los tres ámbitos y que puede proporcionar una clave de lectura más general: la estrecha integración entre los usos civiles y militares de las tecnologías digitales(Michele Mezza lo describió de manera eficaz y con gran cantidad de referencias en su reciente «Muerto en conexiónon. Guerra, medios y democracia en la sociedad de la ciberseguridad, Donzelli Editore, 2024).

Y en los dos teatros de guerra hemos asistido no solo a una mayor intersección entre lo civil y lo militar, sino también a una inversión con respecto a la relación tradicional entre usos militares y usos civiles.

Es tradicional considerar la innovación tecnológica, y por tanto también la digital, como un camino que comienza en el ámbito militar, que no solo financia, sino que dirige la investigación y permite eficaces oportunidades de experimentación sobre el terreno.

Solo posteriormente los productos, directos e indirectos, de la innovación en el ámbito militar se utilizan con fines comerciales en el ámbito civil, de formas que a veces distan mucho de sus objetivos iniciales. El ejemplo más conocido es el de la propia arquitectura de Internet, que fue diseñada en el ámbito militar (con el nombre de Arpanet) para garantizar la permanencia de la capacidad de la red incluso si algunos de los nodos de conexión se volvían inutilizables.

Hoy, en cambio, asistimos cada vez más a la trayectoria inversa: los dispositivos y las prácticas de uso civil de la tecnología digital se utilizan en acciones militares.

El ejemplo más llamativo es el estallido simultáneo, provocado por el ejército israelí, de miles de localizadores en poder de los afiliados a Hezbolá en el Líbano.

Dispositivos totalmente similares a los teléfonos inteligentes que todos llevamos en contacto con nuestro cuerpo, prótesis digitales que se han vuelto indispensables debido a las consecuencias de la transformación digital, se han transformado, gracias también a la red que los conecta, en artefactos mortíferos que han matado y mutilado a sus portadores inconscientes.

Una metáfora simbólicamente poderosa de la posible nocividad de estos dispositivos también en el ámbito civil.

Otro ejemplo se refiere a la práctica más extendida de utilizar los teléfonos inteligentes como cámaras, que consiste en compartir en tiempo real las imágenes que se introducen en la red con descripciones de personas o cosas que pueblan el mundo que nos rodea.

Así es como, en los teatros de guerra, cualquiera, ya sea militar o civil, al compartir imágenes tomadas con su teléfono inteligente con militares cercanos o lejanos, puede dirigir la trayectoria de balas, misiles o drones hacia el lugar donde se encuentran los “enemigos”.

Las infraestructuras digitales

Últimamente se ha hablado mucho de la importancia de las infraestructuras digitales en el ámbito militar, en relación con la red Starlink, construida y gestionada por la empresa SpaceX de Elon Musk, que aparentemente nació para su uso en el ámbito civil.

Pero la utilidad distintiva predominante de esta infraestructura es en el ámbito militar y en la navegación en alta mar.

De hecho, casi todos los demás usos pueden cubrirse con tecnologías distintas de las de los satélites de Starlink, con un rendimiento a menudo mejor y costes incluso inferiores.

Pero donde no llega ninguna fibra, ninguna antena, ningún radioenlace, Starlink no tiene competidores por el momento y ha adquirido, gracias al bajo coste de poner en órbita sus satélites, una ventaja competitiva que solo podrá ser superada dentro de muchos años.

El principal uso de Starlink es en teatros de guerra, donde los demás sistemas de comunicación se averían fácilmente y donde la comunicación entre soldados y entre estos y las drones es indispensable.

Al ser privado, se concede a cambio de dinero o como moneda de cambio para aumentar el poder y los intereses económicos de su propietario. Esto explica, por ejemplo, por qué la red se concedió inicialmente de forma gratuita a Ucrania, pero se impidió su uso para atacar el territorio de Crimea, luego se revocó el uso gratuito y finalmente se volvió a conceder a Ucrania, esta vez a cambio de un pago por parte de EE. UU.

Infraestructura que, en cualquier caso, no es impenetrable, si el ejército ruso en los territorios fronterizos también ha logrado conectarse a Starlink, ‘agujereando’ los sistemas de seguridad.

Pero las infraestructuras digitales en el ámbito militar no son solo las de comunicación. También existen las infraestructuras digitales que permiten la logística de los ejércitos y las civiles que permiten el funcionamiento mismo de los aparatos estatales.

Por ejemplo, los centros de datos y los ordenadores de las fuerzas armadas y de la administración estatal deben ser puestos a salvo. Y las grandes empresas digitales como Amazon y Google se proponen hacerlo, y lo hacen ofreciendo alojamiento en sus centros de datos en territorio estadounidense (Andrea Coveri y Dario Guarascio han hablado de ello en este sitio).

Las infraestructuras digitales, al igual que las infraestructuras de comunicación tradicionales (ferrocarriles, aeropuertos, puertos), son en sí mismas objeto de ataques militares, que también pueden ser ciberataques.

Es la llamada “ciberguerra”, que también se dirige a los componentes digitales, hoy en día vitales, de las infraestructuras materiales tradicionales, logrando inutilizar presas, transportes y energía.

Dado que el espacio orbital de los satélites de Starlink no es un recurso infinito y será objeto de disputa en un futuro próximo, es previsible que la “guerra cibernética” se traslade pronto al espacio y afecte a los propios satélites y a su funcionamiento.

Las armas autónomas

Las armas autónomas(para un análisis detallado, véase «Ética de las máquinas. Dilemas morales para la robótica y la inteligencia artificial», de Guglielmo Tamburrini, Carocci Editore, 2020) son aquellas capaces de seleccionar y atacar un objetivo sin intervención humana.

Una definición tan general puede incluir también dispositivos militares rudimentarios, como las minas antipersona, que explotan solo cuando el peso que las comprime supera un determinado umbral.

Pero el desarrollo efectivo de armas autónomas se produce con el uso, en muchos componentes, de sistemas de telecomunicación e IA. Paralelamente a su desarrollo, se ha intentado definir restricciones a su uso basadas en el Derecho Internacional Humanitario (DIH) en tiempos de guerra.

Un elemento central de estos intentos ha sido el papel del control humano en el uso de los nuevos sistemas. Cuanto más efectiva y extendida sea la supervisión humana, menores serán los riesgos asociados al uso de este tipo de armas.

El ejemplo más común de armas autónomas son los aviones de todo tipo, llamados genéricamente drones.

Si están controlados por control remoto, existe control humano, aunque la distancia entre quien controla el dron y el lugar de la acción, y la interfaz utilizada para guiarlo, hace que una acción de guerra se parezca a un videojuego (también aquí se confunde el uso civil y militar), y, solo por eso, disminuye en el operador humano la percepción de las consecuencias letales y los efectos colaterales de la acción que está llevando a cabo.

Pero controlar el dron por control remoto puede disminuir su eficacia. Si quien controla el dron está muy lejos, hay tiempos de latencia de la señal que pueden ser intolerables. Pero, sobre todo, aunque esté más cerca, existe el riesgo de que los canales de telecomunicación puedan verse perturbados o destruidos.

Si a esto le añadimos el uso de sistemas de IA cada vez más potentes, se dan las condiciones para el desarrollo y el uso cada vez más extendido de drones sin control humano durante la acción.

Tenemos la llamada “munición errante”, a la que se le asigna un objetivo y que permanece en vuelo hasta que el objetivo es avistado y alcanzado.

Tenemos enjambres de drones que se coordinan entre sí durante la acción, sin ningún tipo de control central. Tenemos aviones autónomos, con los que se han experimentado combates con otros aviones también autónomos. Tenemos embarcaciones autónomas, muy utilizadas por la Armada de Ucrania en el Mar Negro.

Y además de aeronaves y embarcaciones, también vehículos autónomos, que el ejército ucraniano ha utilizado recientemente de forma masiva en la batalla de Lyptsi, un pueblo fronterizo de la región de Járkov (de ello habla el sitio web de «Guerre di Rete»).

En todos estos casos, la ausencia de control humano implica la posibilidad de errores en el reconocimiento del objetivo y la incapacidad de evaluar los daños colaterales de la acción o las variaciones del contexto.

Se ha dicho que las máquinas son más fiables que los humanos en cuanto a la posibilidad de cometer errores. Pero esto, señala Guglielmo Tamburrini, solo se refiere a la frecuencia y no a la gravedad de las consecuencias del error, que pueden ser incluso catastróficas. Consideraciones y ejemplos que, también en este caso, remiten a lo analizado y evaluado en el caso civil de los coches autónomos.

Sistemas predictivos de apoyo a la toma de decisiones

La evolución más reciente y preocupante, en la que encontramos todos los principales problemas del uso de la IA en el ámbito bélico, es la de los sistemas de apoyo a la toma de decisiones, sistemas predictivos basados principalmente en sistemas de IA.

También en este caso es evidente la estrecha relación con los sistemas utilizados en el ámbito civil. El ejemplo más apropiado se refiere a los sistemas de apoyo a la toma de decisiones en el ámbito financiero, donde la cantidad de datos utilizados y la velocidad de cálculo sirven para anticipar las decisiones de compra o venta de los competidores, que a su vez utilizan el mismo tipo de sistemas.

La analogía con la decisión de atacar un objetivo en una acción bélica es inmediata, al igual que lo es la analogía sobre las consecuencias catastróficas que pueden derivarse de ello: la crisis financiera de 2008 en el ámbito civil, o el estallido de un conflicto nuclear en el ámbito militar.

Es interesante profundizar en la relación en el ámbito militar entre el decisor humano y el sistema de recomendación que lo asiste: un conjunto socio-técnico donde inevitablemente prevalece el elemento técnico.

El decisor humano en el ámbito militar, al que el sistema de apoyo debería ofrecer elementos de evaluación más sólidos y fiables, a menudo debe tomar decisiones en tiempos cada vez más ajustados. Además, en este caso también existe un sesgo favorable a la máquina:

es más difícil tomar una decisión que no acepte la sugerencia del sistema de apoyo, al que se atribuye la capacidad de considerar cantidades de datos mucho mayores que las conocidas por el decisor.

Tomar una decisión coherente con la sugerencia del sistema es también una justificación eficaz en caso de que la decisión resulte errónea. Este sesgo también opera, por ejemplo, en el ámbito médico: pensemos en el uso de sistemas de apoyo a la toma de decisiones en el momento del diagnóstico.

Hay un caso, del que se ha hablado mucho, relacionado con la guerra entre Israel y Palestina, en cuyo análisis confluyen no solo muchas de las consideraciones hechas hasta ahora, sino que sugiere otras nuevas y dramáticas.

Se trata del sistema de IA “Lavender”, revelado por una investigación de Yuval Abrahm en la revista israelí +972, confirmada en esencia por el ejército israelí.

Lavender tiene como objetivo sugerir “objetivos” en el territorio de Gaza. Los objetivos para matar son los afiliados de Hamás, a cada uno de los cuales, sobre la base de indicios de la más diversa naturaleza, se le asigna un rango (jefe, oficial, soldado raso, escolta), rango que, como veremos, genera efectos significativos en los procedimientos de ‘eliminación’ del objetivo.

También sobre la base de estas pistas se identifican los lugares donde se puede alcanzar el objetivo.

La investigación señala que otro sistema de IA totalmente similar, llamado “The Gospel”,tiene como objetivo identificar objetivos no humanos (depósitos de municiones, rampas de lanzamiento de misiles, centros de mando, centrales eléctricas, redes de distribución de agua, entradas de túneles, etc.).

Veamos más analíticamente el funcionamiento de Lavender tal y como lo describe la investigación de +972 y las implicaciones que se derivan de ella (del informe de Daniele Amoroso de la Universidad de Cagliari en la conferencia anual de Nexa del 13/12/2024).

- Entrenamiento del sistema, es decir, recopilación y clasificación de datos para alimentar el sistema. En esta fase se han definido como indicios para ser considerados pertenecientes al ala militar de Hamás características no unívocas (por ejemplo, el cambio frecuente de dirección). O se han indicado entre los posibles objetivos también tipos protegidos por el DIU, por ejemplo, los operadores de protección civil. O se considera como dato indicativo de la presencia de civiles el número de conexiones telefónicas activas, olvidando que en ese contexto falta la energía eléctrica para recargar los móviles.

- Identificación y validación del objetivo.Es decir, a partir de los datos recopilados (de todo tipo, y acumulados a lo largo de los años, en los que Gaza ha sido el lugar más vigilado del mundo), identificación de posibles objetivos. Decisión de atacar a todos los militantes de Hamas (37 000). Aceptación de un error cuantificable en un 10 %. Equiparación de la sugerencia de Lavender a una ‘orden superior’,como tal, que el operador humano solo puede contradecir en presencia de una grave presunción de error. Tiempos de validación reducidos para garantizar el número de ataques previstos.

- Planificación de los ataques. Se ha optado por atacar cuando los presuntos militantes de Hamás están en casa, para simplificar los procedimientos operativos. Fijación de umbrales de civiles sacrificables, incluidas mujeres y niños, en relación con el rango del objetivo. Desde unas pocas decenas hasta cientos. Uso de munición no ‘inteligente’ (y, por tanto, con mayores márgenes de error) para eliminar a los militantes de bajo rango. Cuestan menos y hay abundantes existencias.

- Ejecución del ataque. No se comprueba la presencia en el hogar del objetivo a atacar después del tiempo transcurrido desde el aviso del ataque.

La narrativa de la IA

Hay un uso de la inteligencia artificial en un contexto de guerra adicional y diferente de los indicados hasta ahora, que se suma a los demás, pero también los contradice.

La investigación sobre el funcionamiento de Lavender ha demostrado que describir el uso de la IA en la guerra como una operación quirúrgica para atacar al enemigo reduciendo al mínimo los daños colaterales es falso. Los daños colaterales se cuantifican en decenas, o incluso cientos, de víctimas civiles, en relación con el rango del objetivo.

Pero hay otra consideración adicional que hacer.

En el caso de la guerra de Gaza, tenemos la oportunidad (y la desgracia) de presenciar un caso real. Y al observarlo, es difícil no considerar que lo que sucedió en Gaza es de hecho independiente del uso de Lavender o de Gospel.

Cuando se lanzan bombas muy potentes sobre un territorio pequeño y densamente poblado, que puede compararse con un hormiguero (y así parece cuando se observan los movimientos de los puntos negros que representan a los habitantes de Gaza, captados por los sistemas de videovigilancia utilizados por los drones), es evidente que se trata de una masacre indiscriminada.

En comparación con esta masacre, el ‘relato’ de la inteligencia artificial se utiliza como justificación de un método muy tradicional de hacer la guerra, similar al que conocimos en la Segunda Guerra Mundial con el punto culminante de Hiroshima y Nagasaki.

Por lo tanto, la narrativa de la inteligencia artificial se utiliza como instrumento de guerra. Esto contribuye a desvelar la retórica positiva de la narrativa de la IA, incluso cuando se utiliza en el ámbito civil.